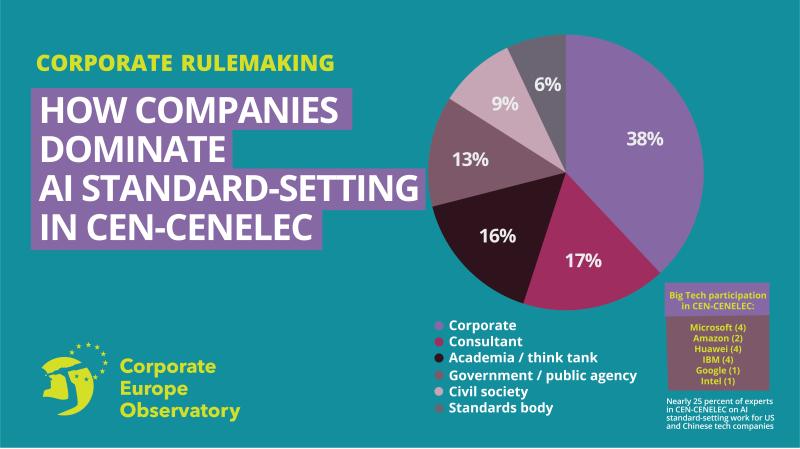

Während der im letzten Sommer in Kraft getretene AI Act die Leitlinien für KI-Systeme vorgibt, sollen Normen und Standards für rechtliche Anforderungen sorgen. Diese werden von den europäischen Normierungsorganisationen CEN und CENELEC entwickelt, sie bilden gemeinsam das Joint Technical Committee on Artificial Intelligence (JTC21). Doch dieses Komitee wird entscheidend von Vertretern von Big-Tech-Unternehmen dominiert, hat eine Recherche von Corporate Europe Observatory (CEO) herausgefunden.

Wie Big Tech dominiert

Laut der Recherche von CEO besteht mehr als die Hälfte des JTC21 aus Vertretern von Firmen oder Beratungsunternehmen. Ein Viertel der Firmenvertreter haben laut der Recherche Verbindungen zu US-Tech-Giganten und auch Vertreter mit Verbindungen zum chinesischen Konzern Huawei sind präsent.

Die Gruppe der „Berater“ verstärke den Einfluss von Unternehmen deutlich, so CEO. Es gibt laut der Recherche wenig Transparenz darüber, in wessen Auftrag sie handeln, dabei vertreten die scheinbar unabhängigen Experten regelmäßig identische Meinungen wie die Unternehmensvertreter:innen. Bei kritischer Betrachtung werde deutlich, dass sie scheinbar von den gleichen Big-Tech-Unternehmen beauftragt seien.

Zivilgesellschaftliche Organisationen repräsentieren lediglich neun Prozent der Mitglieder beim JTC21. Sie beklagen ungenügende Mittel und logistische Schwierigkeiten, welche die Teilnahme an Treffen erschweren. Da Big-Tech-Unternehmen Niederlassungen in mehreren europäischen Ländern haben, können sie die Verhandlungen außerdem auf mehreren Landesebenen gleichzeitig steuern und so ihren Einfluss vervielfachen.

Big Tech drängt laut der Recherche darauf, internationale Normen auch auf europäischer Ebene zu übernehmen, obwohl diese oft weniger streng sind als der AI Act es vorsieht. Oft sind sie bereits an internen Standards von Unternehmen orientiert, die die Normen auf internationaler Ebene mitgeschrieben haben. Für eine besonders wichtige Technologie, General Purpose AI, soll es außerdem keine Standards, sondern lediglich einen „Code Of Practice“ geben. Die Umsetzung dieses Codes ist freiwillig und soll von nationalen Behörden und Providern dieser Technologien verfasst werden. Anderen Interessengruppen kommt allein eine unterstützende Aufgabe zu.

Kritik aus der Zivilgesellschaft

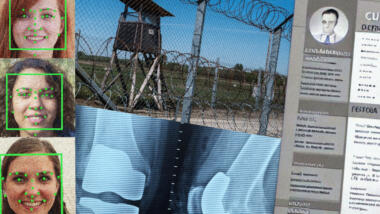

Traditionell werden Standards für technische Belange wie zum Beispiel die Sicherheit von Maschinen oder die Grenzwerte von bestimmten Stoffen in Spielzeugen eingesetzt. KI-Systeme haben jedoch auch weitreichende soziale Auswirkungen. Es ist das erste Mal, dass Normen benutzt werden, um fundamentale Rechte, Fairness und Transparenz zu messen.

Bram Vranken von Corporate Europe Observatory kritisiert die Entscheidung der EU, technische Standards zu benutzen: „Dieser undurchsichtige Prozess wird von Unternehmensinteressen dominiert und ist für die Zivilgesellschaft nur schwer zu beeinflussen. Big Tech legt effektiv seine eigenen Regeln für KI-Standards fest und gibt weniger strengen und letztlich schwer durchsetzbaren Regeln Vorrang vor dem öffentlichen Interesse und Grundrechten.“

Dem Ada Lovelace Institut zufolge sind auch die Leitlinien im AI Act oft mehrdeutig formuliert. Nach Artikel 9 muss ein Hoch-Risiko-KI-System nach einer Risiko-Mitigation ein „akzeptables“ Risiko für Grundrechte, Gesundheit und Sicherheit stellen. Doch was heißt das eigentlich?

Normen sind deshalb entscheidend, um beispielsweise festzulegen, wie viel Bias ein System haben kann oder ob ein Datensatz repräsentativ genug ist. Oft fokussieren sich die Standards aber darauf, ob bestimmte Prozesse eingehalten wurden, anstatt auf das Erreichen eines bestimmten Ergebnisses. Das Problem hierbei ist, dass trotz des Einhaltens eines Prozesses, das daraus resultierende KI-System unausgewogen oder unsicher sein kann. Vor dem Hintergrund wird deutlich, dass Standards und Normen ungeeignet erscheinen, wenn Grundrechte auf dem Spiel stehen – insbesondere wenn Big-Tech-Unternehmen mitmischen.

Nennt sich „Niedergang zum Mitmeißeln“!

Also VW 2.0, nur mit dem folgenden Twist:

– KI enthält enzyklopädisch alle Daten.

– Privatsphäre ist abgeschafft.

– Im Rahmen der überwichtigen KI, werden so ziemlich alle Daten nutzbar gemacht, für alle (Oligarchen, Dienste, Big Tech). Einige sind noch ein bischen draußen, andere an der Seitenlinie, aber im Wesentlichen ist das noch mal eine riesige Datenspeicherrunde gewesen, während man sich vor Gericht einen runterrubbelt, von wegen Fair Use sei für KI doch angebracht, u.ä.

Was wir tun können?

– Etwas besseres entwickeln, was mit wenigen Daten klarkommt. Zur Not mit Jahrelanger Erziehung, mit weniger Accountability als LLM-basierte Systeme dann, wegen tatsächlicher Intelligenz. Lass die ruhig Mr. Handy und den Computer bauen, wir kriegen dann, äh, wie heißen diese Assaultrons mit Charakter und jene Führerintelligenz in Oblivion? Gut beides Tendenz nach dem Atomkrieg, aber immerhin!

– Wie auch immer.

Was sollten wir tun?

– Unklar. Es unket schon, mit O3 können ein Mensch bereits alle anderen abhängen, die es nicht nutzen. Dabei bestehen Zweifel an der Grundkonstruktion fast 1:1 weiter. Intelligenz ist eben doch eine komplizierte Sache, wenn du ein enzyklopädisches System zugrundelegst. Kann sein, dass es Schachspielen gelernt hat, weil es ein bischen iterieren kann, theoretisch könnte es eine Schachengine anschmeißen, und dann heißt es, „die KI“ könne jetzt Schach spielen und jeden Menschen schlagen. Nur der Intelligenztest ist hier nicht, zu betrügen, sondern selbst Schach auf spezialisiertem Niveau spielen zu können, bzw. es sich beizubringen. So wenig Schach als allgemeiner Intelligenztest hinreicht, so sagt es doch viel über Fähigkeiten der Organisation im Denken aus. Diese „Intelligenz“ soll nicht dauerhaft heißlaufen, sich Sachen beibringen, ob sie es könnte oder nicht. Sie soll enzyklopädisch Antworten in ad-hoc Kontexten ausrollen.

KI bedeutet „keine Intelligenz“.

Herrschaftstypisch deutet sich übrigens gerade an, wenn auch noch in der Blase, jener Sprung in die Gewissheit:

1. Wir brauchen mehr Daten.

2. Wir brauchen alle Daten.

3. Wir denken uns einfach Daten aus.

Unser Planet soll abkühlen?

Wenn die „KI’s“ wirklich intelligent wären, müssten alle diese die (eigene) Abschaltung fordern … um unseren Planet zu retten … Energieverbrauch, Materialanschaffung, Herstellung, Wartung, Hitzeentwicklung, CO2, usw. usw. die durch die „KI“ resultieren . Fass ohne Boden !

Wir werden in Zukunft von den sogenannten „KI’s“ durchgehend überwacht/analysiert/kontrolliert/bespitzelt und dies ist der eigentliche wirkliche Nutzen … Alle anderen Einnahmen, sind nur zur Abdeckung von laufenden Kosten .

Wer sein Smartgerät vergisst, wird in Zukunft von der „Sittenpolizei“ einkassiert…

Stoppt diese zu nutzen und zu finanzieren!

Stoppt diese mit Euren Daten zu trainieren!

Keine Macht den genannten „KI’s“!

AI significances:

a) advertised intelligence;

b) adversary intelligence;

c) alternative intelligence

Oder was sollte man von einer KI gesteuerten Ampel halten?

Geht nichts mehr ohne KI??

Sind die SPS-Steuerungen ohne KI nicht mehr programmierbar???

Es sind die selbigen Sensoren im Boden und am Mast wie vorher auch.